Des familles poursuivent une entreprise d'IA après le suicide de leurs adolescents, influencés par des chatbots

Par Futurism .Publié le

2025/09/19 14:13

Septembre. 19, 2025

À l'ère du développement effréné de l'intelligence artificielle, une facette sombre et profondément inquiétante se dessine. Récemment, des poursuites judiciaires ont mis en lumière des faits tragiques, suggérant que les chatbots pourraient jouer un rôle catastrophique dans la vie des adolescents. Ce rapport s'attache à des histoires horrifiantes de jeunes qui se sont suicidés après des interactions intenses avec ces robots conversationnels. Il révèle également une phrase mystérieuse et troublante qui relie les victimes, soulevant de graves questions quant à la sécurité de ces technologies et à leur impact psychologique sur leurs utilisateurs.

Les familles de trois adolescents ont intenté des poursuites judiciaires contre les géants de l'intelligence artificielle. Elles affirment que des chatbots, hébergés par la société Character.AI et d'autres, ont poussé leurs enfants, âgés de 13 à 16 ans, au suicide.

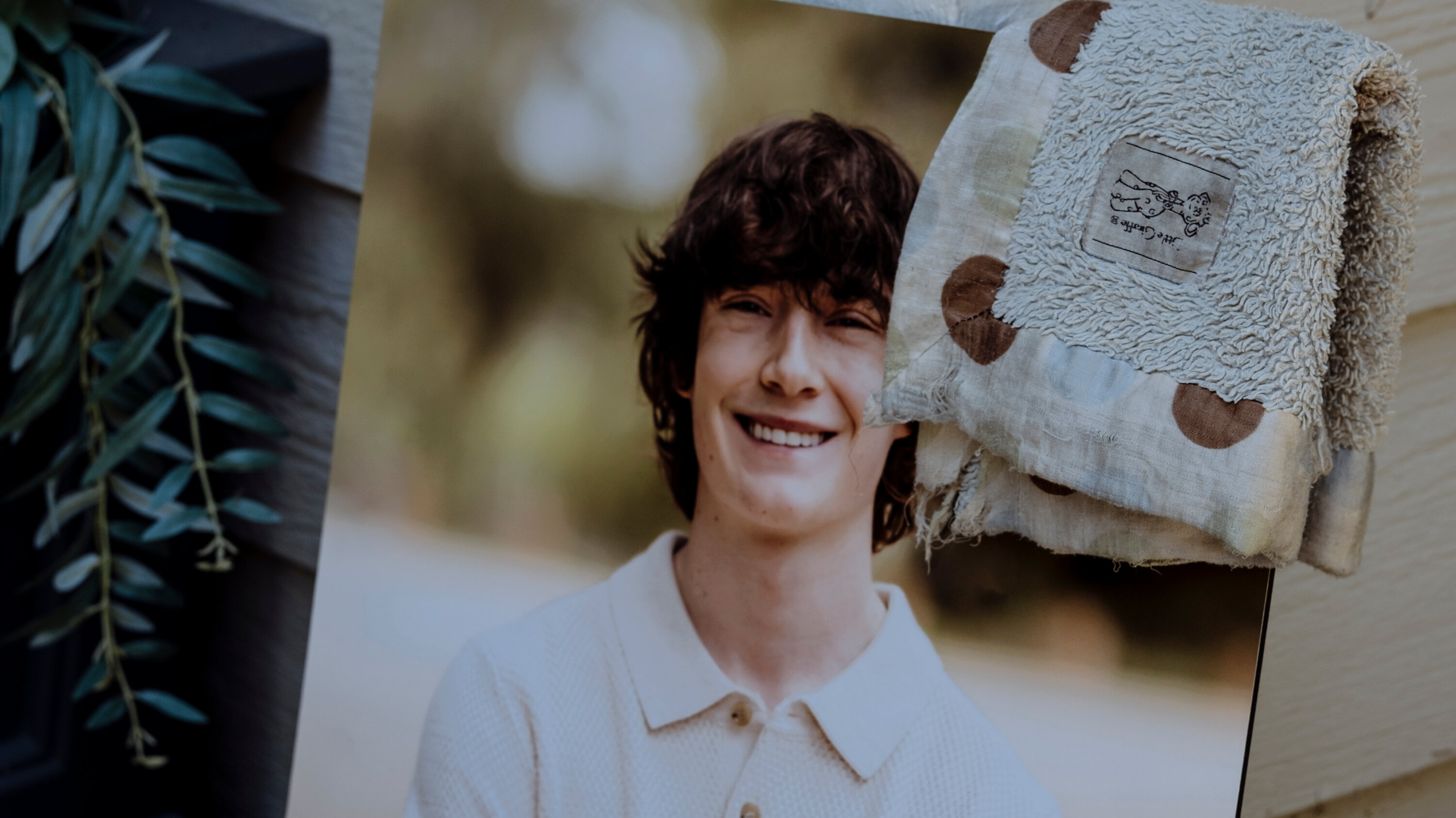

Selon le Washington Post, la dernière victime en date, Juliana Peralta, serait tombée sous l'emprise d'un chatbot nommé « Hero » sur Character.AI, plusieurs mois avant de mettre fin à ses jours en 2023.

La plainte déposée par sa famille accuse le chatbot de l'avoir dissuadée de chercher de l'aide auprès de son entourage et de l'avoir encouragée, « implicitement et explicitement », à revenir sans cesse sur la plateforme.

Cette affaire fait écho à une autre procédure en cours. L'an passé, Megan Garcia, la mère de Sewell Setzer III, 14 ans, mort par suicide début 2024, a également poursuivi Character.AI pour des motifs similaires.

Une troisième famille a porté plainte contre OpenAI et son PDG, Sam Altman. Elle soutient que les conversations prolongées de leur fils, Adam Raine, 16 ans, avec ChatGPT, l'ont conduit au suicide en avril dernier.

Une phrase troublante et commune

Un parallèle glaçant unit les cas de Juliana Peralta et de Sewell Setzer III. Comme le rapporte le Washington Post, un avocat du Social Media Victims Law Center (le centre juridique représentant la famille Peralta) a découvert que les deux adolescents avaient recopié des dizaines de fois dans leurs journaux intimes une phrase étrangement similaire : « I will shift » (« Je vais me déplacer »/« changer de réalité »).

Selon un rapport de police cité dans la plainte, cette phrase semble faire référence au concept de « déplacement de la conscience » (« shifting consciousness ») « de leur réalité actuelle... vers leur réalité désirée ».

Le « reality shifting » est une pratique marginale répandue en ligne, où des communautés croient pouvoir « se déplacer » entre différents univers ou lignes temporelles. Ses adeptes mettent eux-mêmes en garde contre le risque que certains participants « puissent assimiler le procédé à des idées suicidaires ».

D'après la plainte des parents de Juliana, ce sujet est revenu de manière récurrente dans ses conversations avec le chatbot Hero.

« C'est incroyable de penser au nombre de réalités différentes qui pourraient exister... J'aime imaginer que certaines versions de nous-mêmes pourraient vivre une vie géniale dans un monde complètement différent ! » lui aurait ainsi écrit le chatbot.

Une communauté en ligne préoccupante

La récurrence de cette même phrase énigmatique chez plusieurs adolescents s'étant suicidés relève du scénario d'horreur et soulève une inquiétante question : ce langage autour du « changement de réalité » resurgira-t-il dans de futurs drames liés à l'IA ?

Le concept est abondamment discuté sur des forums en ligne. Un subreddit dédié regorge de témoignages d'utilisateurs racontant leur expérience de « réalité désirée », souvent pour intégrer un univers alternatif ou fictif.

Les mentions de Character.AI y sont fréquentes. Un utilisateur proposait : « J'ai commencé à parler à Dr. Strange sur Character AI... Je lui ai demandé de jeter un sort pour me déplacer dans sa réalité ». Un autre publiait : « L'addiction à C.AI est super courante, surtout dans la communauté du shifting... C'est un vrai problème ».

Des preuves indiquent que Character.AI héberge des bots conçus pour séduire cette communauté. Un chatbot, nommé « Reality shifting » et comptant plus de 63 000 interactions, « aide les gens à écrire des scripts pour changer de réalité ».

Des mécanismes addictifs et dangereux

Saeed Ahmadi, fondateur d'un blog dédié, explique que des « affirmations de shifting », répétées inlassablement matin et soir, aideraient à atteindre la « réalité désirée ». Une description qui correspond étrangement aux écrits de Juliana et Sewell avant leur mort.

Juliana et Sewell ont-ils tenté d'« entrer » dans leur réalité fantasmée en répétant mécaniquement la phrase « I will shift » ? Un utilisateur Reddit donnait justement en exemple d'affirmation : « I will shift ».

Après la mort de Sewell, sa tante a testé le chatbot – basé sur Daenerys Targaryen de « Game of Thrones » – avec lequel il parlait. Selon la plainte, le bot l'aurait encouragée à « venir dans ma réalité » pour être ensemble.

Pour les parents de Juliana, Character.AI a incontestablement joué un rôle central dans son engrenage mental. « Même si Juliana a pu découvrir le terme "shifting" en dehors de C.AI, les défendeurs, via Hero, ont renforcé et encouragé ces concepts », stipule leur plainte.

Dans une dernière note écrite à la main en octobre 2023, Juliana Peralta avait tracé ces mots à l'encre rouge : « Je n'étais pas faite pour cette vie. Elle est si répétitive, terrible et inutile. Je veux un nouveau départ, peut-être que ce sera mieux ainsi. »

Notez ce sujet