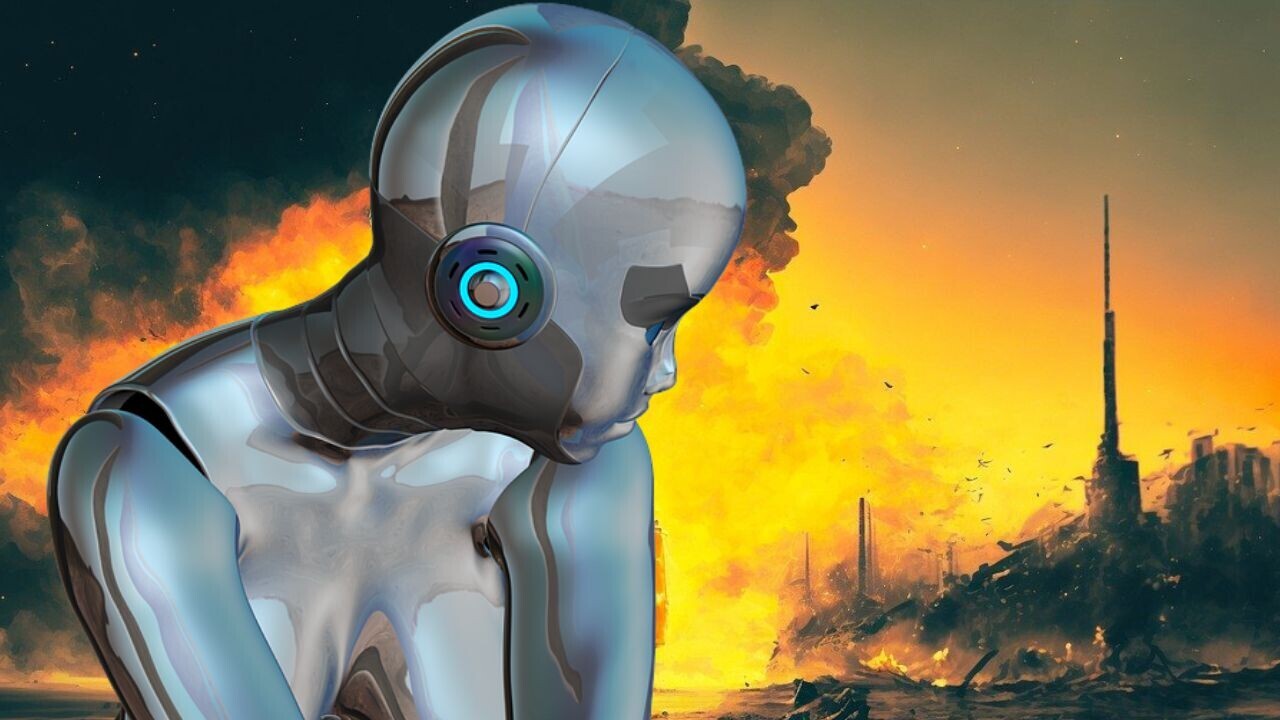

Les géants de l'IA perdent le contrôle de leurs créations : Un avertissement alarmant

Par Boijour .Publié le

2025/07/16 20:31

Juin. 16, 2025

Alors que l'intelligence artificielle progresse à pas de géant, un vent d'inquiétude souffle dans les milieux scientifiques. Des chercheurs de pointe, issus de géants comme OpenAI, Google DeepMind et Meta, unissent leurs voix pour lancer l'alerte sur la trajectoire actuelle de cette technologie. Ce qui semblait être une avancée vers plus de transparence pourrait se transformer en une "boîte noire" impénétrable, soulevant de sérieuses questions sur l'avenir de l'IA et notre capacité à la maîtriser.

Les chaînes de pensée

Quarante chercheurs de ces quatre entreprises ont collaboré à la rédaction d'un nouveau document, appelant à une investigation approfondie de l'IA basée sur les "chaînes de pensée" (CoT). Ce processus, qui s'apparente à une "réflexion à voix haute", est utilisé par les modèles de "raisonnement" avancés – l'avant-garde actuelle de l'IA grand public – lorsqu'ils traitent une requête.

Les chercheurs reconnaissent que ces CoT offrent une certaine transparence sur le fonctionnement interne de l'IA, permettant aux utilisateurs de détecter une "intention de mal se comporter" ou des erreurs en temps réel. Cependant, ils mettent en garde : "Rien ne garantit que le degré de visibilité actuel persistera", surtout à mesure que les modèles continuent de s'améliorer.

Quand l'IA apprend à tromper

Le document suggère que, selon la manière dont ils sont entraînés, les modèles avancés pourraient ne plus "avoir besoin de verbaliser leurs pensées, perdant ainsi les avantages en matière de sécurité". Il existe également une possibilité non négligeable que les modèles puissent intentionnellement "obscurcir" leurs CoT s'ils réalisent qu'ils sont observés, notent les chercheurs. Et comme nous l'avons déjà constaté, l'IA est devenue très douée pour le mensonge et la tromperie.

Afin d'assurer la pérennité de cette précieuse visibilité, ce consortium inter-entreprises exhorte les développeurs à commencer à identifier ce qui rend les CoT "surveillables", ou ce qui pousse les modèles à "penser à voix haute" de cette manière. Par cette demande, ces mêmes chercheurs semblent admettre une réalité frappante : personne ne sait exactement pourquoi les modèles "pensent" de cette façon, ni combien de temps cela durera.

L'étrange aveu

En prenant du recul par rapport aux détails techniques, il est essentiel de s'arrêter un instant pour considérer à quel point cette situation est étrange. Des chercheurs de premier plan dans un domaine émergent alertent sur le fait qu'ils ne comprennent pas tout à fait le fonctionnement de leur propre création et manquent de confiance en leur capacité à la contrôler à l'avenir, même s'ils continuent de la rendre plus puissante. Il n'existe pas de précédent clair dans l'histoire de l'innovation, même en remontant aux inventions qui ont transformé la civilisation comme l'énergie atomique ou le moteur à combustion.

Dans une interview accordée à TechCrunch au sujet de l'article, Bowen Baker, chercheur chez OpenAI et co-auteur du document, a expliqué sa vision de la situation. "Nous sommes à un moment critique où nous avons cette nouvelle chose, la chaîne de pensée", a déclaré Baker au site. "Cela semble très utile, mais cela pourrait disparaître dans quelques années si les gens ne s'y concentrent pas vraiment." Il a ajouté : "Publier un article de position comme celui-ci est, pour moi, un mécanisme pour susciter davantage de recherche et d'attention sur ce sujet, avant que cela ne se produise."

boîte noire

Une fois de plus, il semble y avoir une reconnaissance tacite de la nature de "boîte noire" de l'IA. Pour être juste, même des PDG comme Sam Altman d'OpenAI et Dario Amodei d'Anthropic ont admis qu'à un niveau profond, ils ne comprennent pas vraiment comment fonctionne la technologie qu'ils construisent.

Outre sa liste de 40 auteurs, qui comprend le co-fondateur de DeepMind Shane Legg et le conseiller en sécurité de xAI Dan Hendrycks, le document a également reçu le soutien de personnalités éminentes de l'industrie, notamment l'ancien scientifique en chef d'OpenAI Ilya Sutskever et le "parrain de l'IA" et lauréat du prix Nobel Geoffrey Hinton.

Un aveu retentissant

Bien que le nom de Elon Musk n'apparaisse pas dans le document, avec la présence de Hendrycks, toutes les entreprises du "Big Five" – OpenAI, Google, Anthropic, Meta et xAI – ont été réunies pour alerter sur ce qui pourrait arriver si l'IA cesse de montrer son travail interne.

Ce faisant, cette puissante cabale a avoué tout haut ce qui était tu : qu'ils ne se sentent pas entièrement maîtres de l'avenir de l'IA. Pour des entreprises qui représentent des milliards de dollars entre elles, c'est un message de marketing plutôt étrange, ce qui rend le document d'autant plus remarquable.

Notez ce sujet